データのロード

データ ウェアハウス (Data DB) は、レポートおよびデータ分析に使用されるシステムであり、ビジネス インテリジェンスのコア コンポーネントと見なされます。Data DB は、1 つ以上のソースからの統合データの中央リポジトリです。現在および過去のデータを 1 か所に統合し、分析レポートの作成に使用されます。

典型的な抽出、変換、ロード (ETL) データ ウェアハウスは、ステージング、データ統合、およびアクセス レイヤーを使用して、その主要な機能を収容します。Insight では、このスキーマはレコードおよび指標 レベルで統合されており、Data DB にデータを保存できます。

Data DB に保存されているデータは、運用システムからアップロードされます。Data DB でレポートに使用される前にデータ品質を確保するために、データは運用データ ストアーを通過した後、追加の操作としてデータ クレンジングが必要になる場合があります。Insight でこれらの要件は、実行プランに基づいてデータ ロード エンジンを介して実装されます。

外部ソースからのデータが Data DB にコピーされます。トランザクション データベースに一定のリクエストを送信するのではなく、Insight は後になってこのデータを使用してレポートを作成します。この場合、システムに追加の負荷がかかることはないため、リソースはわずかに使用されるだけです。また、データを前処理して指標を集計できるため、レポートにも役立ちます。

Data DB のデータは、2 つのバリアントで更新できます。

- 完全なデータ更新: 古いデータはすべて完全に消去され、新しいデータに置き換えられます。このプロセスは特定の時間サイクルに従って発生するため、Data DB のデータが外部システムの実際のデータより遅れる場合があります。この方法は、データの量が少なく、更新間隔が頻繁ではない場合に推奨します。たとえば、外部データが更新されていない営業時間外に 1 日に 1 回。

- 増分データ更新: システムは、変更されたデータのみを再ロードします。

前の演習手順では、データは外部ソース システムから直接使用されました。すべてのレコードと指標には、「オンデマンド」タイプのストレージがありました。このサンプル手順では、データのロードを構成し、Data DB(データ ウェアハウス) を活用する方法を学習します。

データ ロードの指標を準備

前の演習では、注文プール指標を作成しました。以下の手順では、この指標のデータ ロードを実行する必要があります。

- Studio の、[ドキュメント ツリー] について、[指標] から 注文プール指標を見つけます。この指標をコピーし、名前をOrder Pool Storedに変更して開きます。

- ストレージ セクションで[変更] をクリックします。[保存 (上書き論理を使用)] を選択します。

- 時間オプション セクションで、指標が事前集計される最終時間を選択します。たとえば、デフォルトでは 1 日に設定されており、残りのディメンションの同じセットを持つ 1 日間のすべてのデータが 1 行に集約されます。この場合のレポートの最小データ間隔は 1 日です。ユーザーがレポートを月ごとに分類した場合、データはそれに応じて集計されます。

- [OK] をクリックします。

- 指標を保存します。表示されたら [適用] をクリックします。

実行プランを作成する

実行プランは、どのデータをいつロードするかを説明する Insight ドキュメントです。外部システムから Data DB のデータの定期的な更新を管理します。

指標のデータをダウンロードするには、2 つのステップで実行プランを作成します。最初のステップでは、オンデマンド レコードが作成され、Data DB に既存のテーブルがないため、すべてのデータが SQL Server のテンポラリー テーブルにロードされます。2 番目のステップとして、指標のデータがロードされ、必要なデータがすでにサーバー上にあるため処理できます。データのロードが完了すると、レコードのテンポラリー テーブルが削除されます。

- [ドキュメント ツリー] のStudio で、[実行プラン] を右クリックし、[新しい実行プラン] を選択して名前を付け、[OK] をクリックします。

-

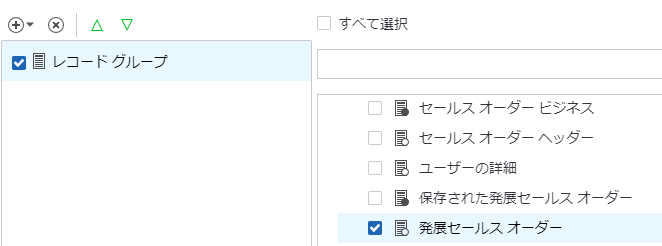

プラス記号をクリックして、[レコード グループの追加] を選択します。

-

指標のソースである販売注文拡張レコードを選択します。

- プランに 2 番目のステップを追加します: プラス記号をクリックして、[指標グループの追加] を選択します。

- Order Pool Stored指標を選択します。

- 実行プランを保存します。

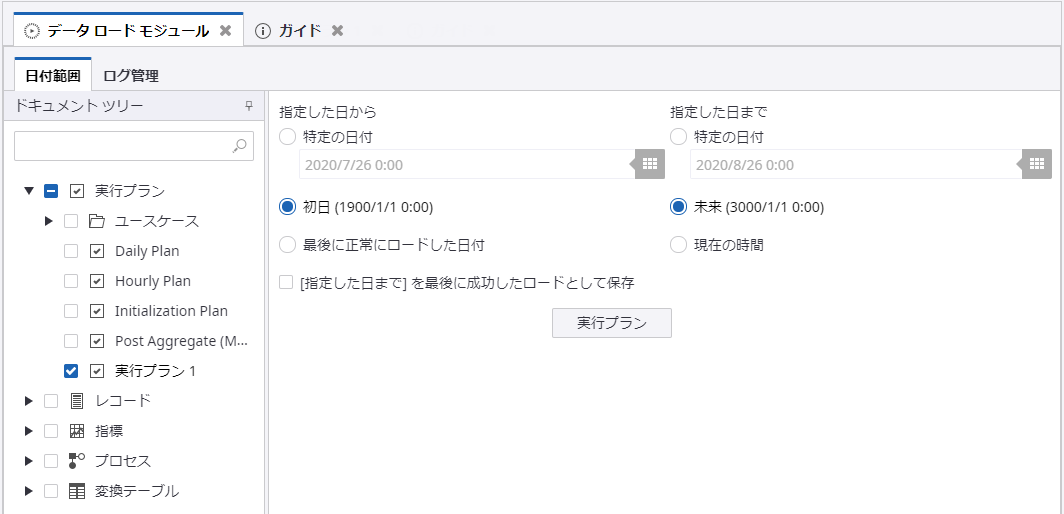

- [データのロード] をクリックして、データ ロード モジュールに進みます。デフォルトでは、正しいドキュメント (実行プラン) がすでに選択されています。時間間隔を選択します: [初日 (1/1/1900 0:00)] および [未来 (1/1/3000 0:00)]。

-

[実行プラン] をクリックし、プロセスが完了するまで待ちます。

複数のソースからのデータを使用

上記の手順は、データ ソースが 1 つしかない単純な場合に有効です。ただし、多くの場合、異なるソースからのデータを結合またはマージする必要があります。この場合、ベスト プラクティスは、いくつかの外部ソースから生データを Data DB にダウンロードし、後で指標の処理、データの変更、組み合わせに使用することです。このアプローチを適用するには:

- [ドキュメント ツリー] で、セールス オーダー延長レコードを見つけてコピーし、保存されたセールス オーダー延長に名前を変更します。

- レコードを開き、[変更] ボタンをクリックしてストレージタイプを [保存 (上書き論理を使用)] に変更します。[OK] をクリックします。

- レコードを保存します。

-

Order Pool Stored指標のソースレコードを変更します。

- [ドキュメント ツリー] で指標を見つけます。

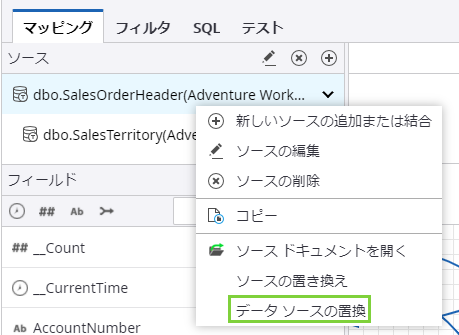

-

レコード名を右クリックして、[ソースの置き換え] を選択します。

- 保存されたセールス オーダー延長 を選択し、[OK] をクリックします。

- 指標を保存します。

-

次に、レコードと指標のデータをダウンロードする必要があります。オプションとして、上記の手順で説明したように、実行プランを介して実行することができます。別のオプションとして、複数のソースからデータを個別にダウンロードできます。レコードのためデータをロードします。

- [データをロード] をクリックします。

- 左側で、保存されたセールス オーダー延長 レコードを選択します。

- [初日 (1/1/1900 0:00)] および [未来 (1/1/3000 0:00)] を選択します。

- [データをロード] をクリックし、プロセスが完了するまで待ちます。

-

指標のデータをロードします。

- 同じデータ ロード モジュールで、Order Pool Stored指標を選択します。

- [初日 (1/1/1900 0:00)] および [未来 (1/1/3000 0:00)] を選択します。

- [データをロード] をクリックし、プロセスが完了するまで待ちます。

この演習を完了すると、データのロードを構成し、実行プランを作成し、複数のソースからデータをロードできるようになります。